Introduction à l'intelligence Artificielle

1 .Qu'est-ce que l'Intelligence Artificielle ?

Définir l'IA de manière simple et comprendre son ampleur.

1. Définition de l'IA

L'IA

est un vaste domaine des sciences informatiques qui a pour but de créer

des machines capables de réaliser des tâches qui nécessitent

normalement l'intelligence humaine.

On peut la résumer en deux approches :

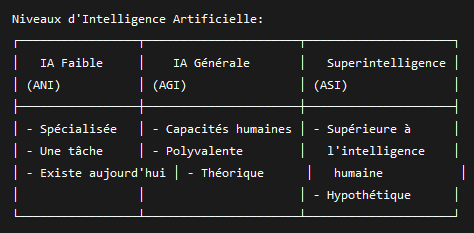

IA Faible (ou étroite) : Spécialisée dans une tâche précise. C'est l'IA que nous utilisons aujourd'hui.

Exemples : Recommandations Netflix, assistant vocal (Siri, Alexa), voiture autonome, filtre anti-spam.

IA Forte (ou générale) : Une intelligence hypothétique qui posséderait des capacités cognitives égales ou supérieures à celles des humains, capable de raisonner, de planifier et de résoudre des problèmes dans n'importe quel domaine. Elle n'existe pas encore.

2. Les applications de l'IA (Partout autour de nous !)

Santé : Aide au diagnostic médical (analyse d'images radios), découverte de nouveaux médicaments.

Transport : Voitures autonomes, optimisation du trafic.

Finance : Détection de fraudes, trading algorithmique.

Vente et Marketing : Systèmes de recommandation (Amazon, Spotify), chatbots pour le service client.

Divertissement : Génération d'images (DALL-E, Midjourney), personnages de jeux vidéo intelligents.

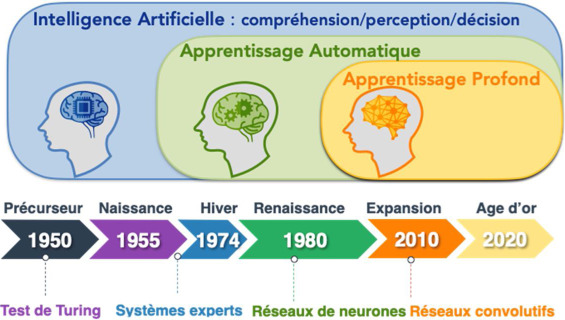

2. Un bref historique de l'IA

Comprendre les origines, les périodes d'enthousiasme et les doutes qui ont façonné l'IA.

1. Les précurseurs (Années 40-50)

1950 : Le Test de Turing Alan Turing propose un test pour évaluer l'intelligence d'une machine : si un humain ne peut pas la distinguer d'un autre humain lors d'une conversation, la machine est considérée comme intelligente.

1956 : La naissance officielle Le terme "Artificial Intelligence" est officialisé lors de la conférence de Dartmouth, considérée comme l'acte de naissance du domaine.

2. L'âge d'or et les premiers hivers (Années 60-80)

Optimisme : Les premiers programmes résolvent des problèmes logiques et algébriques. Les chercheurs prédisent que l'IA forte est pour bientôt.

Premier "hiver de l'IA" (70s) : Le manque de puissance informatique et l'incapacité à résoudre des problèmes complexes entraînent une baisse des financements.

3. Le renouveau et l'explosion (Années 90 à aujourd'hui)

Les années 90 : Le succès de l'IA basée sur les données et les statistiques (Machine Learning) prend le pas sur l'approche logique pure.

Années 2010 : La combinaison de Big Data (énormes quantités de données), de puissance de calcul (GPUs) et d'algorithmes avancés (Deep Learning) provoque une révolution. Des percées majeures ont lieu dans la reconnaissance d'images et la voix.

3. L'Apprentissage Automatique (Machine Learning - ML)

Le ML repose sur l'idée de trouver une fonction f qui mappe les entrées X aux sorties Y:

Y = f(X) + ε

Où ε représente l'erreur qu'on cherche à minimiser.

1. Définition du Machine Learning

Le

Machine Learning est une méthode pour parvenir à l'IA. Au lieu de

programmer explicitement une machine avec des règles ("si X, alors Y"),

on lui donne un algorithme et des données, et elle apprend d'elle-même à

trouver des modèles et à faire des prédictions.

Analogie : Au lieu d'apprendre à un enfant à reconnaître un chat en lui donnant une liste de règles (oreilles pointues, moustaches...), vous lui montrez des milliers de photos de chats et de non-chats. Son cerveau apprendra par lui-même les caractéristiques d'un chat.

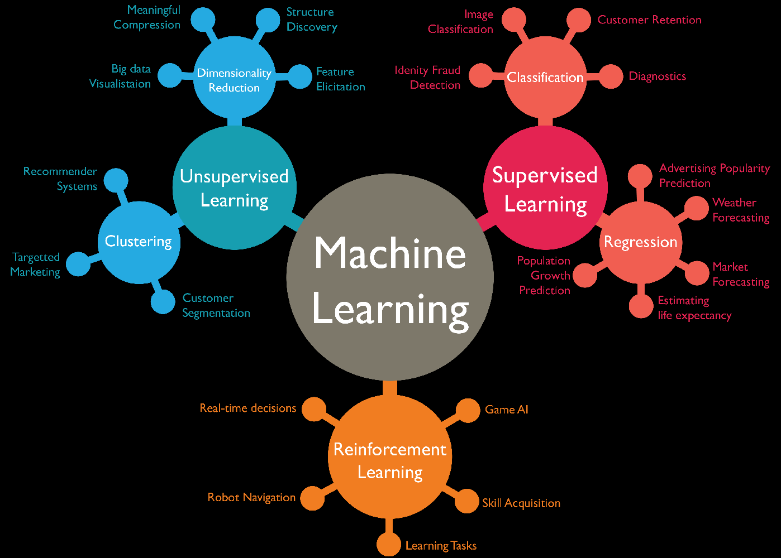

2. Les trois types principaux de Machine Learning

Apprentissage Supervisé : L'algorithme apprend sur des données étiquetées.

Exemple : Pour reconnaître des emails spam, on donne à l'algorithme un dataset d'emails déjà étiquetés "spam" ou "non spam".

Tâches : Classification (spam/pas spam), Régression (prédire un prix).

Apprentissage Non Supervisé : L'algorithme trouve des patterns dans des données non étiquetées.

Exemple : Segmenter une clientèle en groupes basés sur leurs habitudes d'achat, sans savoir à l'avance quels groupes existent.

Tâches : Clustering (groupement), Réduction de dimension.

Apprentissage par Renforcement : L'algorithme apprend par essais-erreurs en interagissant avec un environnement pour maximiser une récompense.

Exemple : Un programme qui apprend à jouer aux échecs en jouant des milliers de parties contre lui-même.

4 .L'Apprentissage Profond (Deep Learning - DL)

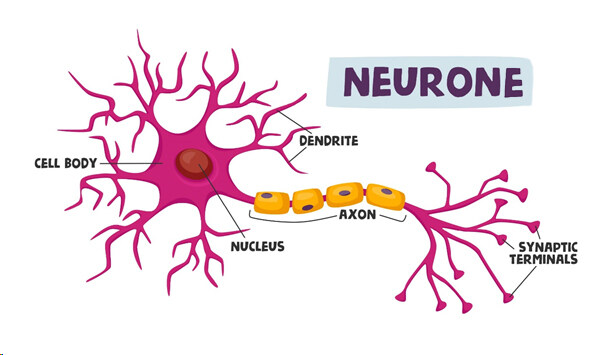

Comprendre que le Deep Learning est un sous-ensemble puissant du ML, inspiré par le cerveau humain.

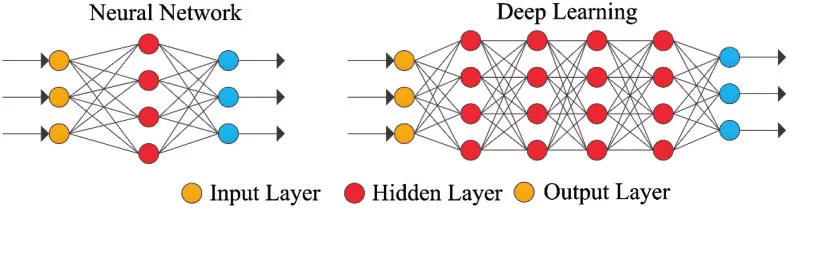

1. Définition du Deep Learning

Le Deep Learning est une technique de Machine Learning qui utilise des réseaux de neurones artificiels

avec plusieurs couches ("deep" = profond). Ces réseaux sont capables

d'apprendre des représentations de données de plus en plus abstraites.

Analogie : Reprenons l'exemple de la reconnaissance de chat.

Couche 1 : Les neurones identifient des bords simples (lignes, courbes).

Couche 2 : Combinez ces bords pour former des formes (yeux, nez).

Couche 3 : Combinez ces formes pour reconnaître un museau, des oreilles.

Couche 4 : Reconnaît un chat entier.

2. La clé du succès du Deep Learning

Réseaux de neurones profonds : Architectures complexes avec de nombreuses couches.

Big Data : Nécessite d'énormes quantités de données pour apprendre efficacement.

Puissance de calcul : Utilisation massive de processeurs graphiques (GPUs) pour des calculs parallèles.

3. Applications phares du Deep Learning

Vision par ordinateur : Reconnaissance faciale, voitures autonomes.

Traitement du Langage Naturel (NLP) : Traducteurs automatiques (Google Translate), assistants vocaux.

Synthèse de contenu : Génération d'images, de texte, de musique (GPT, DALL-E).

5 . Synthèse, Comparaison et Récapitulatif

Consolider les connaissances et comprendre la hiérarchie entre ces concepts.

1. La relation hiérarchique : IA > ML > DL

L'IA est le domaine le plus large.

Le ML est le moyen le plus courant actuellement de réaliser de l'IA.

Le DL est une technique très puissante et spécialisée du ML, responsable des avancées les plus récentes.

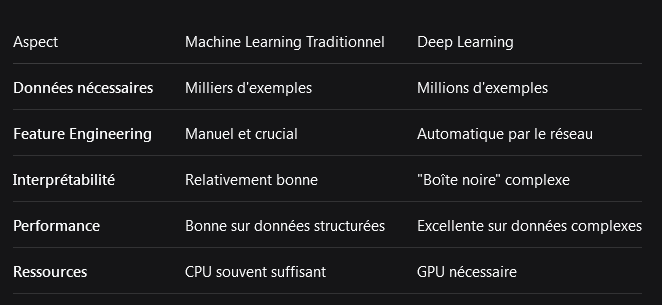

2. Tableau comparatif résumé